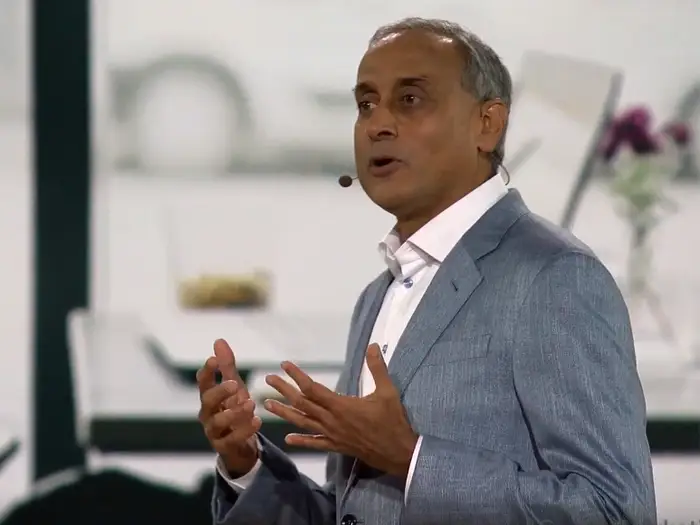

Prabhakar Raghavan declaró el sábado a Welt Am Sonntag que a veces pueden dar respuestas falsas pero convincentes.

El jefe de búsquedas de Google ha advertido del peligro de confiar en que los chatbots de inteligencia artificial ofrezcan siempre información precisa.

Prabhakar Raghavan declaró el sábado a Welt Am Sonntag que a veces pueden dar respuestas falsas pero convincentes.

"Este tipo de inteligencia artificial de la que hablamos actualmente puede llevar a veces a algo que llamamos alucinación", declaró al periódico alemán.

Y añadió: "Esto se expresa entonces de tal manera que una máquina da una respuesta convincente pero completamente ficticia".

El lunes, Google aprovechó una presentación para desvelar su chatbot de IA llamado Bard, con el que espera rivalizar con ChatGPT.

Sin embargo, un anuncio de Bard mostró que daba una respuesta inexacta a una pregunta sobre el telescopio espacial James Webb.

Las acciones de la empresa matriz de Google, Alphabet, cayeron bruscamente a raíz del error y de los crecientes temores sobre la amenaza que supone ChatGPT para su dominio de las búsquedas.

Raghavan declaró a Welt Am Sonntag que Google sentía la "urgencia" de hacer público Bard, "pero también sentimos la gran responsabilidad. Definitivamente no queremos engañar al público".

"Estamos estudiando cómo integrar estas posibilidades en nuestras funciones de búsqueda, especialmente para las preguntas para las que no hay una única respuesta", añadió.

Los comentarios de Raghavan llegan después de que algunos criticaran a Google y al CEO de Alphabet, Sundar Pichai, por el lanzamiento "apresurado" y "chapucero" de Bard.

Maarten Bosma, antiguo ingeniero de investigación de Google Brain, la división de IA de Alphabet, tuiteó que la presentación mostraba que la empresa no se estaba tomando la IA lo suficientemente en serio.

Google no respondió inmediatamente a una solicitud de comentarios de Insider realizada fuera del horario laboral habitual.

ENLACE ORIGINAL: Google Search Chief Warns AI Can Give 'Fictitious' Answers, Report Says (businessinsider.com)